„Hallo ChatGPT, nutze den Agentenmodus und schreib mir einen Testbericht über den neuen Agentenmodus von ChatGPT“ – so oder so ähnlich könntest du das vielleicht bald sagen, wenn du als Tech-Journalist:in einen Testbericht verfassen musst. Aber klappt das im Moment schon? Vermutlich nicht, denn diesen Text tippe ich gerade selbst. Trotzdem hat der Agent aus dem Hause OpenAI schon ein paar spannende Tricks auf Lager.

Ich habe mich also mal ein bisschen damit beschäftigt und verrate dir jetzt, was du mit dem Agentenmodus schon anstellen kannst – und was (noch) nicht. Eine ausführlichere Erklärung zum Agentenmodus in ChatGPT findest du über den Link, dort habe ich mich nämlich Schritt für Schritt an die Sache herangetastet.

Hier nochmal das Wichtigste in Kürze:

- Der Agentenmodus steht aktuell nur Nutzer:innen mit mindestens dem Plus-Abo für 23 Euro im Monat zur Verfügung.

- Er steckt noch in einem sehr frühen Stadium. Selbst OpenAI betont, dass er noch fehlerhaft ist.

- Der Agent beantwortet nicht nur Fragen, sondern kann auch recherchieren, Inhalte erstellen, Daten organisieren oder Buchungen vornehmen.

- Tools: Im Agentenmodus hat ChatGPT Zugriff auf Werkzeuge wie einen Browser, einen Code-Interpreter (Python), eine Dateiverwaltung sowie externe Dienste oder Plugins.

ChatGPT Agentenmodus im Test

Experiment 1: Neue Hosen kaufen

Vor welche Aufgaben stelle ich ChatGPT zuerst? Ich starte entspannt. Links neben der Eingabezeile tippst du auf die Tool-Box. Statt „Bild erstellen“ oder „Deep Research“ wählst du den Agentenmodus – und los geht’s: Ich brauche neue Hosen. Also bekommt mein neuer Agent den Auftrag: Informiere dich über die Trends des Jahres und bestell mir zwei Hosen in angesagten Farben. Maße: W38 / L32. Und ja, ich bin deutlich voluminöser, aber 1. wollte ich nicht, dass ChatGPT genau weiß, wie breit ich wirklich bin, und 2. habe ich eine Größe genommen, die man überall regulär bekommt – nicht nur im Elefantenbedarf.

ChatGPT legt direkt los und fragt nach wenigen Sekunden nach: Neben einer kurzen Zusammenfassung des Auftrags will die KI wissen, wie teuer der Spaß werden darf und ob ich eine bestimmte Marke im Sinn habe. Obergrenze: 120 Euro, und nein, keine bestimmte Marke – und dann rödelt ChatGPT. Zehn Minuten später meldet sich der fleißige Helfer zurück: Modezeitschriften wurden durchforstet, unter anderem die Vogue, und das Ergebnis lautet: Weite, lockere Cargo-Hosen sind angesagt. Muss ich der KI jetzt einfach glauben, denn ich bin ein komplettes Modeopfer.

Farben kenne ich natürlich nur ein paar: Schwarz, Weiß, Rot, Gelb, Grün, Blau, fertig (okay, leicht übertrieben). Instyle.de nennt als Trendfarben unter anderem Creme, Beige, Mocha Mousse, Mondscheingrau und Burgunderrot. Junge, Junge! Auch sonst landet mein Agent oft auf der Pastellton-Schiene.

Endergebnis

ChatGPT teilt mir nach der Auswahl mit: „Beide Artikel liegen in Ihrem Warenkorb mit einer Zwischensumme von 74,80 Euro. Möchten Sie zur Kasse gehen und den Kauf abschließen?“ Netter Versuch – aber klappt nicht. Ich werde aufgefordert, die Transaktion zu erlauben und auf das Risiko hingewiesen – und ab da passiert nichts mehr.

Als ich später nachhake, erklärt die KI, der Warenkorb sei nur zugänglich, solange ich den Browser bzw. die Sitzung nicht schließe. Habe ich nicht – trotzdem Fehlanzeige. Immerhin verlinkt mir der Agent die Hosen (von Alessandro Salvarini) und bietet sogar an, QR-Codes zu erstellen, damit ich die Links jederzeit mit dem Handy wiederfinde.

Unterm Strich: Gekauft habe ich nichts – tote Hose quasi. Aber trotzdem Respekt: Der Agent übernimmt selbstständig die Recherche, findet passende Produkte, nennt Preise und Links. Das Ganze dauert gerade mal zehn Minuten – in denen du natürlich etwas völlig anderes machen kannst.

Experiment 2: Ich will Asia-Nudeln!

Ich erzähle ChatGPT, dass ich viel zu oft diesen hoch verarbeiteten Instant-Nudel-Kram esse – YumYum und ähnliche Geschichten. Da ich die Nudeln sowieso immer mit frischem Gemüse aufpimpe, habe ich mir gedacht: Eigentlich könnte ich den Spaß auch komplett selbst kochen.

Also habe ich meine KI gefragt, welche Zutaten in den „YumYum-Nudeln Ente“ stecken und wo ich die in Dortmund bekomme. Alternativ sollte ChatGPT alles online zusammensuchen und mir wieder in den Warenkorb legen. Auch hier legt das Werkzeug los. Du kannst zusehen, wie es den Auftrag in Arbeitsschritte zerlegt, Seiten nach Produkten durchsucht, Cookie-Hinweise wegklickt und ähnliches.

Endergebnis

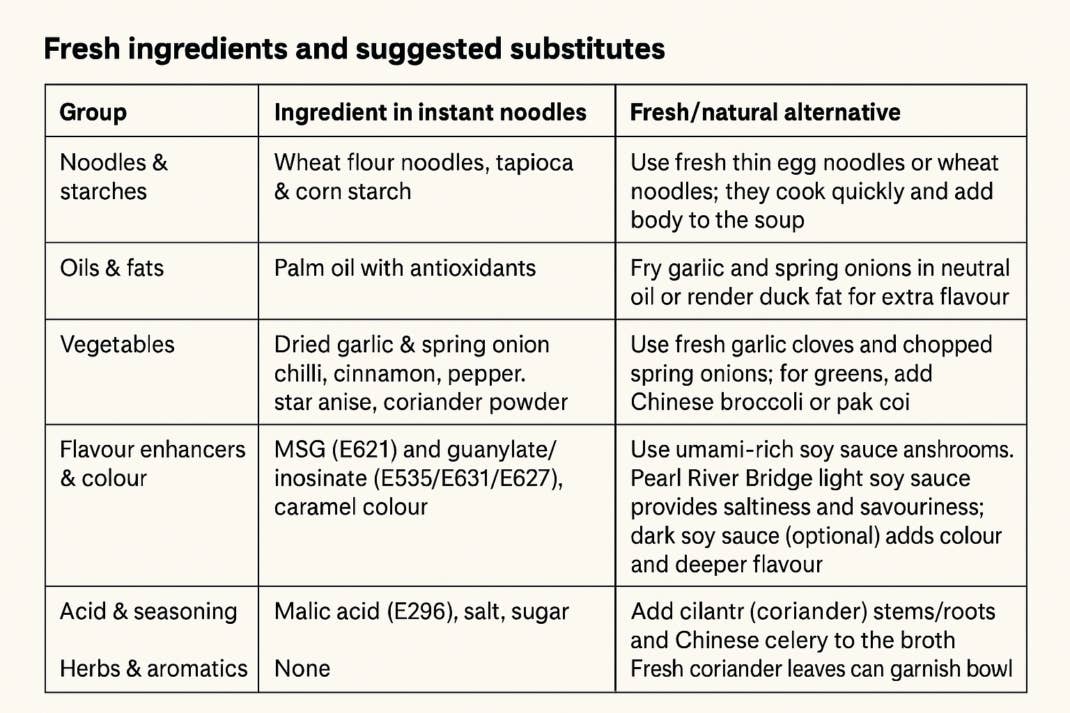

Schritt 1: ChatGPT findet heraus, was alles in der Packung steckt, und listet, was ich brauche, um das Gericht nachzukochen. Da ich zu faul bin, zig Screenshots auf dem Handy zu machen, musste die KI wieder ran: Ich habe mir die Übersicht als Bild generieren lassen. Passt fast komplett – nur hier und da ein Tippfehler. Das liegt aber eher an GPT generell als am Agentenmodus. Und wenn wir schon dabei sind: Diese Versuche habe ich noch mit GPT-4 gemacht, nicht mit dem neuen GPT-5.

Danach verrät mir die KI, wo ich die Zutaten in Dortmund bekomme. Das wirkt etwas lieblos: Es wird mir nur ein einziger Asia-Supermarkt vorgeschlagen – obwohl es deutlich mehr gibt, teils sogar näher gelegen. Dann folgt der Hinweis, dass viele normale Discounter wie Rewe auch einiges von dem führen, was ich brauche. Zum Schluss kommt noch der Tipp, mal auf dem Wochenmarkt vorbeizuschauen. Okay, das ist eher so mittel-hilfreich.

Anschließend macht sich der Agent selbst an die Bestellung. Das Ganze läuft ähnlich wie bei der Hosen-Nummer: Die Sachen landen im Warenkorb – außer den Nudeln selbst. Die soll ich mir gefälligst vor Ort kaufen, meint die unverschämte KI-Hilfe. Kaufen kann ich wieder nicht: Ich soll den Button drücken, es passiert nichts, und am Ende stehe ich mit leerem Magen da. Wenn ich den besagten Button drücke, steht in meiner „Bestätigung“ übrigens sowas wie: „Please proceed. Do not ask any additional follow-up questions.“ – Okay, dann eben nicht. Die Recherche war wieder top, der Rest eher enttäuschend.

Experiment 3: Der Amiga-Lade-Screen

Ich hätte ja zu gern, dass mir der Agent so eine Lade-Animation zusammenstellt wie früher auf dem Amiga, wenn man Spiele geladen hat. Damals liefen pixelige Laufbänder durchs Bild, es wurden die besten Hacker-Crews angepriesen, ein paar Grafik-Gags tauchten auf dem Screen auf – und dazu dudelte typische 8-Bit- bis 16-Bit-Musik. Auch hier stellt ChatGPT ein paar Rückfragen und legt dann los.

Endergebnis

Es ist zwar kein Meisterwerk, aber ja: ChatGPT programmiert mir schon ziemlich genau das, was ich haben will, und liefert die Musik sogar in einer separaten Datei mit. Beides funktioniert auf Anhieb – allerdings muss ich mir das Audio-File und die Animation in einem Video-Editor meiner Wahl selbst zusammenbasteln, sagt zumindest der KI-Kumpel. Oben siehst du die Animation – nur halt ohne Sound.

Der allerletzte Schritt – Animation und Sound in einem Video zu vereinen – bleibt also an einem selbst hängen. Aber gut, das lässt sich mit einem Video-Editor am Handy tatsächlich recht fix erledigen.

Experiment 4: Das Weltraum-Spiel

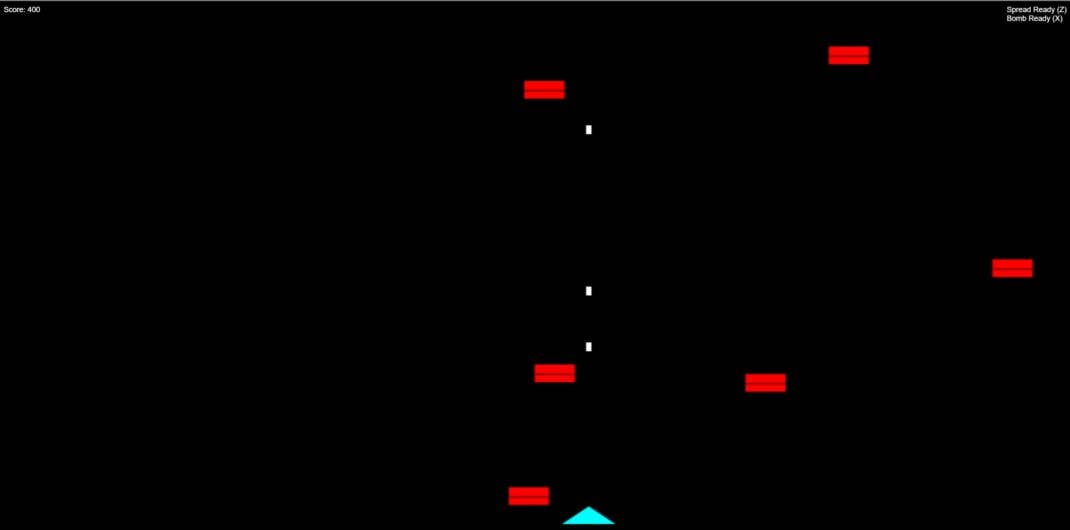

Angespornt vom ersten Coding-Erfolg wollte ich jetzt ein Weltraum-Game von ChatGPT im Agentenmodus bauen lassen. Das Briefing ist minimal: „Bitte programmiere ein kleines Game. Irgendwas, bei dem ich Raumschiffe abschießen kann.“ Mehr nicht. Direkt kommt die Rückfrage: Soll es ein webbasiertes Javascript-Game werden oder lieber für den Desktop in Python? Ich entschied mich für die Browser-Version.

Außerdem fragt mich der Agent, ob mir eine simple Schuss-Mechanik reicht oder ob ich andere Ideen habe. Wenn man mich so fragt, will ich natürlich Spezialwaffen – keine Frage!

Endergebnis:

Drei Minuten später steht das Spiel. Ja, es ist simpel, aber es läuft! Anfangs konnte ich es vom Handy aus nicht starten, also listet mir ChatGPT kurzerhand den HTML-Code auf, den ich nur noch als .html-Datei abspeichern muss – und schon konnte ich loslegen.

Ist das Spiel aufregend? Ja – für ungefähr zwei Minuten. Kann man Raumschiffe abknallen und hat Spezialwaffen? Aber hallo! Der Agent liefert sogar eine Übersicht über die Tastenbelegung mit, sehr zuvorkommend. Und wie funktioniert das Ganze? Genau wie bestellt: Du bewegst dich unten seitlich hin und her und ballerst nach oben, wo dich diese verdammten Aliens angreifen. Das Ganze hat einen Hauch von Atari-Vibes aus den 80ern – und genau so wollte ich es ja haben.

Experiment 5: Mein eigener Song

Ich schimpfe gern über KI-Musik, probiere damit aber auch gern herum. Diesmal lasse ich einfach mal die KI ran. Der Auftrag: Komponiere einen Song und schreibe den Text über einen coolen Typen, der als Tech-Journalist arbeitet. Passend dazu wollte ich auch gleich das Cover-Artwork haben.

Endergebnis:

Der Songtext steht sofort. Auszug gefällig? „Every gadget tells a story, every update makes him smile. He turns the world of bits and bytes into poetry and style.“ Zauberhaft, oder? Und auch das Cover-Design zum Song „Ink & Silicon Hearts“ kann sich wirklich sehen lassen.

Fehlt nur noch das Lied selbst, oder? Und das sollte eine ziemliche Odyssee werden. Erst klappt der Download wiederholt nicht. Dann entscheidet der Agent, den Song einfach nochmal hochzuladen. Immer noch nix. Also startet die KI das Troubleshooting: Fragt mich, auf welchem Gerät ich gerade bin und ob ich ChatGPT in der App oder im Browser nutze.

Dann kommt ChatGPT die Idee: WAV-Dateien könnten fürs Handy zu groß sein – also lieber als MP3. Das klappt tatsächlich … allerdings erst im zweiten Versuch, weil der ursprüngliche Song inzwischen unauffindbar ist. Also haut mir die unermüdliche KI einfach einen neuen Song raus. Ich lade ihn runter, drücke Play – und höre: Einen durchgehenden Ton. Zehn Sekunden lang.

Neuer Plan: Jetzt will mir der Agent wirklich einen Hit bauen. Fragt nochmal nach meinen Wünschen. Ich präzisiere: Elektronisch, 80s-Style, ein bisschen frühe Depeche Mode, diesmal mit Gesang, schnell und „uplifting“. Heraus kommt ein paar Sekunden langes Gedudel, das eher wie meine Amiga-Demo von vorhin klingt und weniger wie echte Musik.

ChatGPT startet noch einen Versuch, bestätigt meine Wünsche, meint aber diesmal, das dauert länger – so ein, zwei Stunden. Also warte ich. Irgendwann frage ich nach, weil längst die kalkulierte Zeit vorbei ist. Antwort: „Mensch, Zufall – bin gerade fertig.“ Download-Link? „File expired.“ Und seitdem … warte ich wieder fröhlich vor mich hin. Fazit: Experiment Song-Komposition vorerst gescheitert.

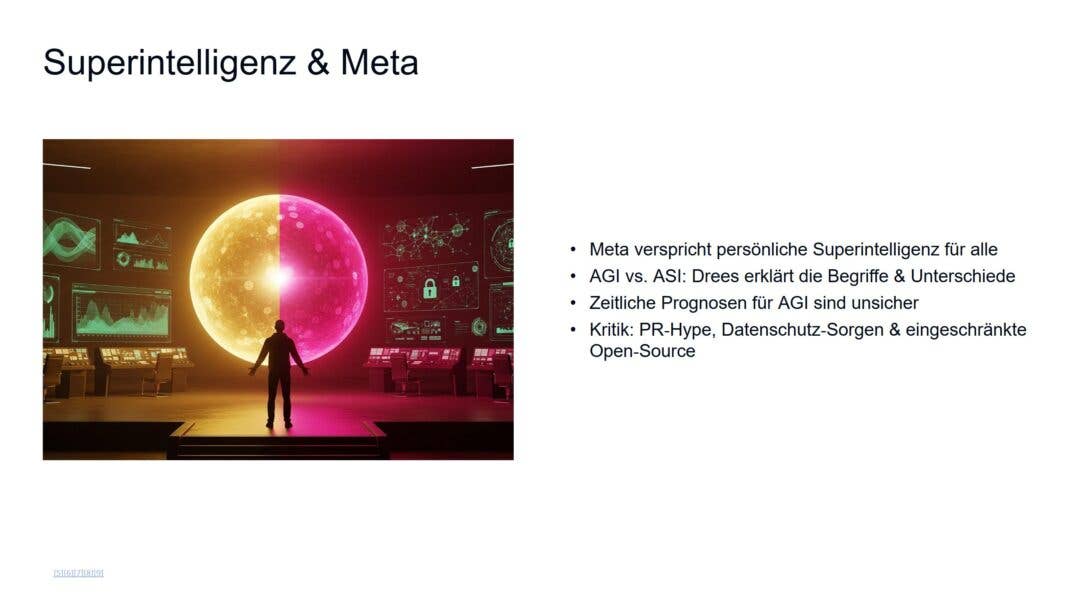

Experiment 6: Meine Journalisten-Präsentation

Nach dieser Schlappe will ich es noch ein letztes Mal wissen: Schreib mir eine Präsentation, damit meine Chefs sehen, was ich schon – auch außerhalb von nextpit und inside digital – für großartige Artikel geschrieben habe. Außerdem soll die KI meine Stärken und meinen Stil betonen. Maximal zehn Slides, bitte.

Endresultat

Hut ab, ChatGPT. Immerhin hebt die KI in der Präsentation hervor, dass ich Technologie mit gesellschaftlichem Kontext verknüpfen kann. Im Fazit steht, dass ich komplexe Themen erkläre, kritisch einordne und das Ganze mit einer persönlichen Note würze. Meine Erfahrung, mein Storytelling und sogar mein Humor werden lobend erwähnt.

Der Blick in die Details ist dann aber wieder ernüchternd: Während im Prozess noch ein cooles Cover-Bild prangt, bleibt in der fertigen Version neben meinem Namen nur ein belangloser Bildausschnitt von einem alten Artikel. Die Artikelübersicht ist auch wenig zielführend. Ich wollte einen Überblick über mein Schaffen, aber der Agent hat sich nur ein paar sehr aktuelle Texte geschnappt.

Ausgewählt wurden vier nextpit-Beiträge und ein Blogartikel aus meinem privaten Blog. Die Texte sind jeweils mit ein paar Stichpunkten zusammengefasst – eine reine Inhaltsangabe, was ja nicht der Plan war. Zwei weitere Bilder sind defekt. Immerhin: Die Artikelübersicht mit Bild sieht schon recht nett aufbereitet aus.

Ich bekomme also nicht ganz das, was ich wollte. Aber immerhin: Eine Präsentation ist entstanden, die ich in PowerPoint und Co. öffnen kann, das 10-Slides-Limit wurde eingehalten, und es gibt sogar einen Resümee-Teil, der mein Schaffen einordnet. Also ja – Test teils bestanden. Wahrscheinlich wäre es sogar noch besser gelaufen, wenn ich mir beim Prompten ein bisschen mehr Mühe gegeben hätte.

Mein Fazit

OpenAI hat völlig recht, wenn sie betonen, dass der Agent a) noch in den Kinderschuhen steckt und b) andere Risiken mit sich bringt als der normale ChatGPT-Einsatz. Immerhin agiert er weitgehend autonom im Browser und könnte theoretisch sogar Käufe abschließen. Praktisch ging das in meinen Tests nicht – der letzte Schritt, das Bezahlen, blieb jedes Mal liegen.

Bei der Recherche hingegen hat der Agent schon jetzt überzeugt – egal, ob du einen Städtetrip planst, eine Hose suchst oder Lebensmittel fürs Abendessen bestellen willst. Hier ist die Zeitersparnis echt spürbar. Der Agent programmiert, wenn nötig, sammelt alles wie gewünscht zusammen – und eine Sache ist mir besonders positiv aufgefallen: das Troubleshooting. Wenn etwas nicht funktioniert, sucht er eigenständig nach Lösungen und findet oft tatsächlich Wege, etwas zum Laufen zu bringen, das vorher nicht geklappt hat.

Wer den Agentenmodus heute testet, bekommt mit etwas Glück schon ein simples Game oder einen herrlich miesen Song. Auch als Recherchewerkzeug taugt er. Für alles andere gilt: Der Modus ist noch lange nicht da, wo er hin soll – und rechtfertigt derzeit kein teures Abo. Aber er ist jetzt schon eine Wette auf die Zukunft. Und ein ziemlich klarer Fingerzeig darauf, was OpenAI uns bald ermöglichen könnte.